En los últimos meses se ha empezado a hablar de un concepto aparentemente nuevo asociado a la fotografía: la “fotografía computacional”, entendida no tanto como el “revelado” digital de las imágenes a través de software, sino la «captura» de las imágenes mediante procesos donde intervienen tanto el hardware como el software. El procesamiento de las imágenes ha estado siempre ahí, pero en los últimos tiempos se ha ido “acercando” más al sensor mismo de la cámara.

Con “acercando” al sensor, nos referimos a que el procesamiento mediante software se ha ido llevando cada vez más cerca del proceso de captura de la imagen. O del vídeo, ahora que los métodos computacionales se están trasladando también a este formato. Esto quiere decir que los métodos y algoritmos que hacen que podamos, por ejemplo, recrear un modo retrato con desenfoque selectivo, se aplican a través de componentes tradicionales como los procesadores de imagen, y de componentes hardware diseñados específicamente para estas tareas.

Para qué se usa

La fotografía tradicional se ha basado, desde su nacimiento, en el aprovechamiento de la óptica empleada para llevar la luz hasta el soporte encargado de capturarla. Ya fuera una placa fotosensible, un carrete o un sensor, la luz pasa a través de un sistema de lentes que conforman los objetivos, hasta llegar al fotocaptor. Efectos como el desenfoque selectivo del fondo, por ejemplo, se deben al uso de una óptica en la que la apertura es muy grande.

Por otro lado, cuanto más grande es el sensor, más acusado es el efecto de desenfoque selectivo. La cantidad de luz que captan los fotorreceptores de uno grande es mucho mayor que la cantidad de luz que capturan los fotorreceptores de los sensores pequeños que se usan en los teléfonos móviles.

La fotografía computacional, en última instancia, se usa para compensar las carencias de los elementos empleados en la construcción de las cámaras. En una SLR Digital, como la Canon EOS 5D Mark IV, por ejemplo, también se usa la fotografía computacional. En las cámaras de fotos, de hecho, se ha usado para, por ejemplo, reducir el ruido de imagen en fotografías hechas con sensibilidades ISO altas, o el viñeteado asociado a ópticas de tipo gran angular.

También se emplea para recrear efectos como el HDR, combinando varias imágenes en una sola o para ofrecer la posibilidad de realizar exposiciones múltiples, eligiendo el modo de superposición (digital) más conveniente. Así pues, la fotografía computacional no es un concepto tan novedoso. Lo que sí es nuevo es su adopción por parte de la telefonía móvil.

La IA como revulsivo

En los procesadores de imagen clásicos, el repertorio de tareas que se pueden realizar sobre las imágenes está limitado a unas pocas. Además, vienen programadas de un modo inamovible a través de firmware. El firmware es un tipo especial de software pensado para realzar un número de tareas prefijado en el momento de su desarrollo y sin que sea posible instalar aplicaciones o realizar actualizaciones de un modo cotidiano.

Por otro lado, las imágenes requieren para el procesamiento de todos sus píxeles componentes optimizados para trabajar en paralelo. Los procesadores clásicos son buenos para tareas secuenciales, donde una instrucción se ejecuta detrás de otra. Pero para procesar miles de operaciones al mismo tiempo, no. Con la llegada de los procesadores de imagen, esto se solventó, pero solo en parte, al estar limitados por la rigidez en cuanto a los tipos de procesamiento que se pueden abordar.

Con iniciativas como el SoC Kirin 970 y su NPU, Huawei consiguió introducir un mecanismo para ampliar la cantidad de operaciones computacionales que se pueden realizar sobre las fotografías. Además, al estar la NPU en el propio SoC, es posible hacer que el procesamiento sea muy rápido y en paralelo. De hecho, es posible realizar operaciones sobre todos los píxeles que llegan desde el sensor, y en tiempo real. Y en el caso del Kirin 980, también es posible realizar operaciones sobre vídeo.

Reconocimiento de imágenes

En una fotografía realizada con un Huawei Mate20 Pro, por ejemplo, el procesamiento computacional empieza ya de forma muy cercana al sensor, combinando cuatro píxeles para conseguir fotos de 10 Mpx de alta calidad a partir de un sensor de 40 Mpx. También podemos tener las fotos de 40 Mpx. Al mismo tiempo, se pueden recrear instantáneas con zoom 5x, combinando información del sensor 3x de 8 Mpx y el de 40 Mpx.

Esto forma parte de las habilidades del DSP, pero con las NPUs es posible recrear otros efectos más elaborados, como la simulación de apertura de diafragma, o el desenfoque selectivo del fondo para retrato, de un modo mucho más preciso que usando solamente el ISP (Image Signal Processor).

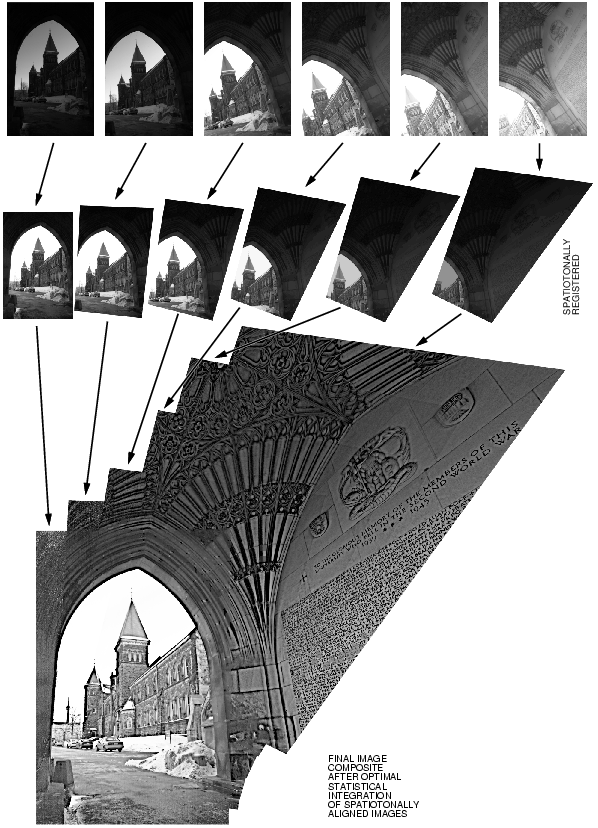

El Modo Noche es también fruto de la fotografía computacional: se capturan varias imágenes seguidas con diferentes sensibilidades y tiempos de exposición y se alinean perfectamente a partir de la identificación de elementos comunes a las diferentes fotos, tales como líneas rectas. De hecho, en fotos donde no haya geometrías evidentes, puede que tengamos fotos “movidas” como resultado.

El reconocimiento de imágenes permite identificar qué se está fotografiando para aplicar ajustes óptimos sobre ellas. Esto se hace mediante técnicas de IA, a partir de modelos estadísticos “entrenados” a partir de cientos de miles de imágenes.

El vídeo también es computacional

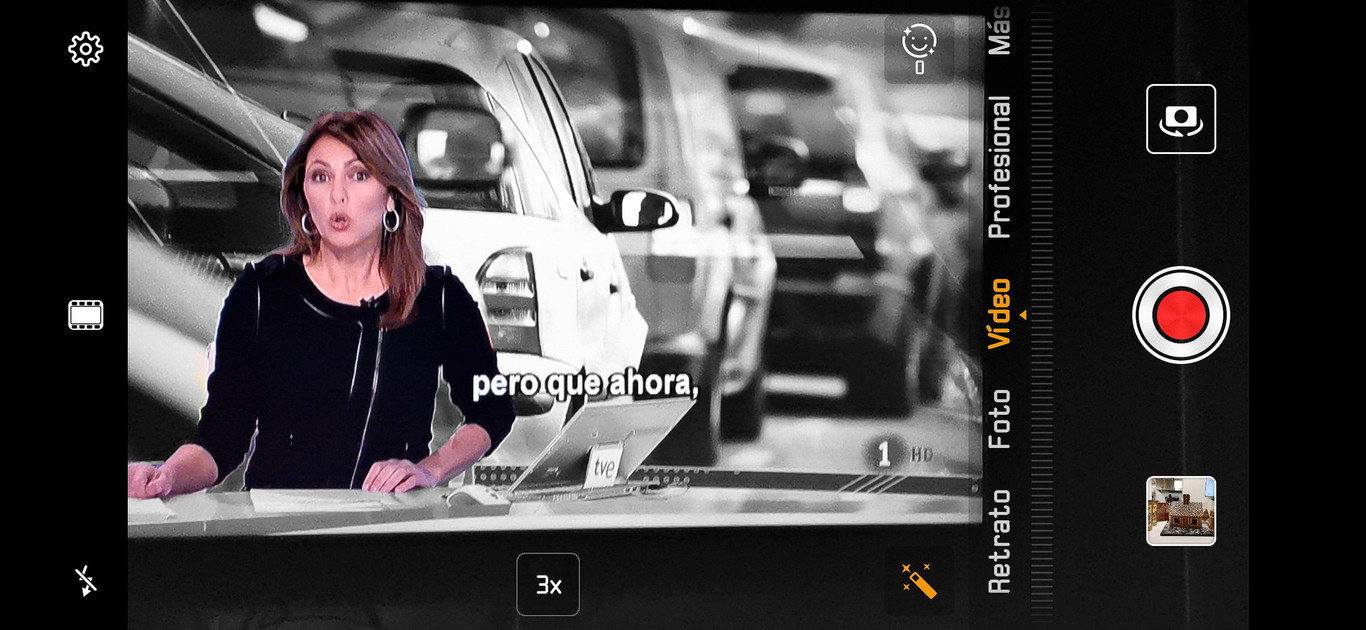

Con la llegada del Kirin 980, el nuevo procesador de Huawei, es posible también aplicar efectos sobre el vídeo. Efectos como el Color con IA o el desenfoque selectivo del fondo. En el caso del vídeo, la fotografía computacional se deja ver más aún si cabe.

Por ejemplo, si hacemos una foto mientras grabamos vídeo con un efecto de IA como el color con IA que deja en blanco y negro todo lo que no sean las personas, esta foto será totalmente en color.

Esto nos dice que el procesamiento de las imágenes para recrear el efecto se lleva a cabo “después”, en la NPU doble del Kirin 980. Es un caso típico de procesamiento computacional, siguiendo una tendencia que hace factible superar las limitaciones ópticas de las cámaras de los smartphones.

Una tendencia con mucho futuro

A medida que se optimicen los procedimientos de IA y los procesadores tipo NPU aumenten su potencia de procesamiento aún más, veremos más efectos y mejoras en esta disciplina de la fotografía computacional. Y hasta es posible que se lleve a las cámaras dedicadas, incluyendo las profesionales. Efectos como el HDR, por ejemplo, ya se han integrado en modelos Pro.

A medio plazo podremos ver cómo se usan sensores de más megapíxeles, así como se manejan vídeos de hasta 4K mediante técnicas computacionales. Ahora estamos limitados a resoluciones Full HD, por ejemplo.

Así pues, hay que recordar que las fotos (y vídeos) que vemos en nuestros smartphones ya no solo dependen de la óptica y el sensor, sino también de la NPU, el procesador de imagen y la CPU.

Fotos | Huawei, HDR de Wikipedia, HDR de Huawei, red neuronal de Wikipedia y Manu Arenas